type

status

date

slug

summary

tags

category

icon

password

Language

项目简介

- CogVLM2 是由清华大学团队发布的新一代开源模型系列。

- 2024年5月24日,发布了Int4版本模型,只需16GB显存即可进行推理。

- 2024年5月20日,发布了基于llama3-8b的CogVLM2,性能与GPT-4V相当或更优。

模型特点

- 显著提升关键指标,如TextVQA, DocVQA。

- 支持8K文本长度和1344*1344图像分辨率。

- 提供中英文双语模型版本。

模型详细信息

- 基座模型:Meta-Llama-3-8B-Instruct

- 语言:英文和中英文双语

- 模型大小:19B

- 任务:图像理解,对话模型

- 文本长度:8K

- 图片分辨率:1344*1344

模型使用

最低配置要求

CogVlM2 Int4 型号需要 16G GPU 内存就可以运行,并且必须在具有 Nvidia GPU 的 Linux 上运行。

Model Name | 19B Series Model | Remarks |

BF16 / FP16 Inference | 42GB | Tested with 2K dialogue text |

Int4 Inference | 16GB | Tested with 2K dialogue text |

BF16 Lora Tuning (Freeze Vision Expert Part) | 57GB | Training text length is 2K |

BF16 Lora Tuning (With Vision Expert Part) | > 80GB | Single GPU cannot tune |

部署步骤

模型下载

- 这里从 huggingface 上下载模型

- 如果使用AutoDL算力平台可以使用

source /etc/network_turbo进行学术加速 ,unset http_proxy && unset https_proxy取消加速

下载代码

安装依赖

cd basic_demopip install -r requirements.txt- 如果始终下载不了,可以采用下面

requirements.txt

代码修改

vim web_demo.py启动WebDemo

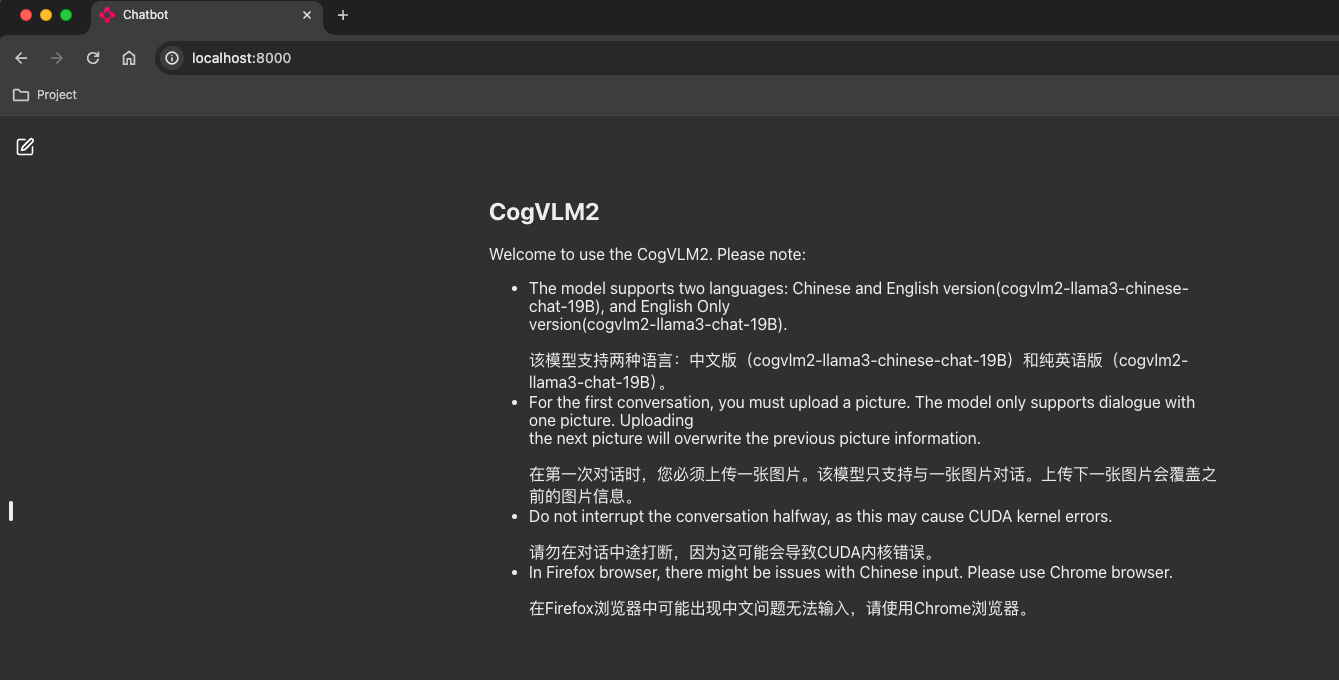

访问

本地则访问 :

http://localhost:8000如果是AutoDL 使用ssh代理来访问 , 输入yes, 如何粘贴密码即可

- 页面

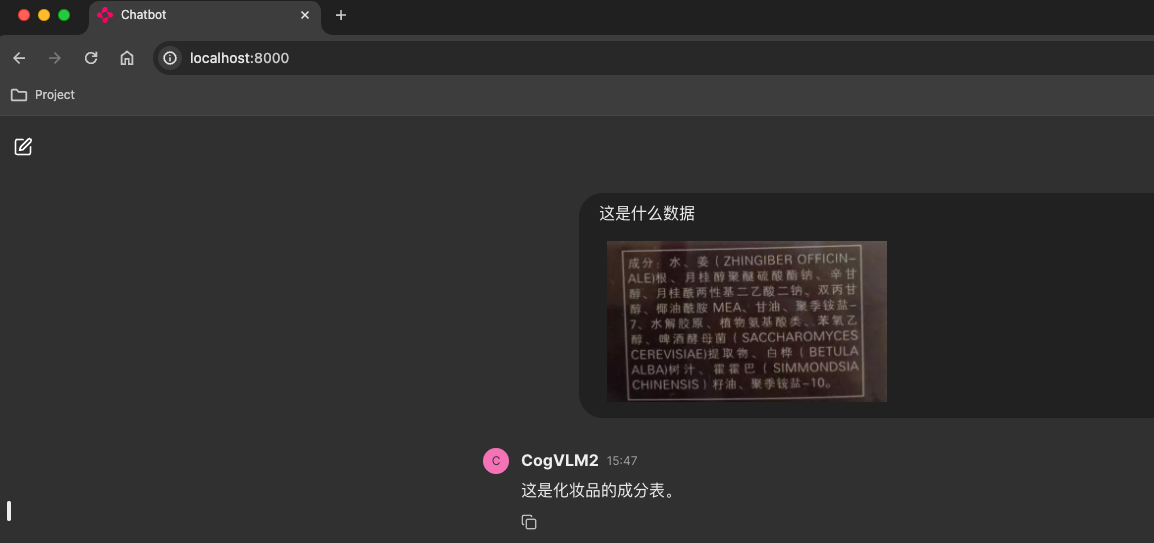

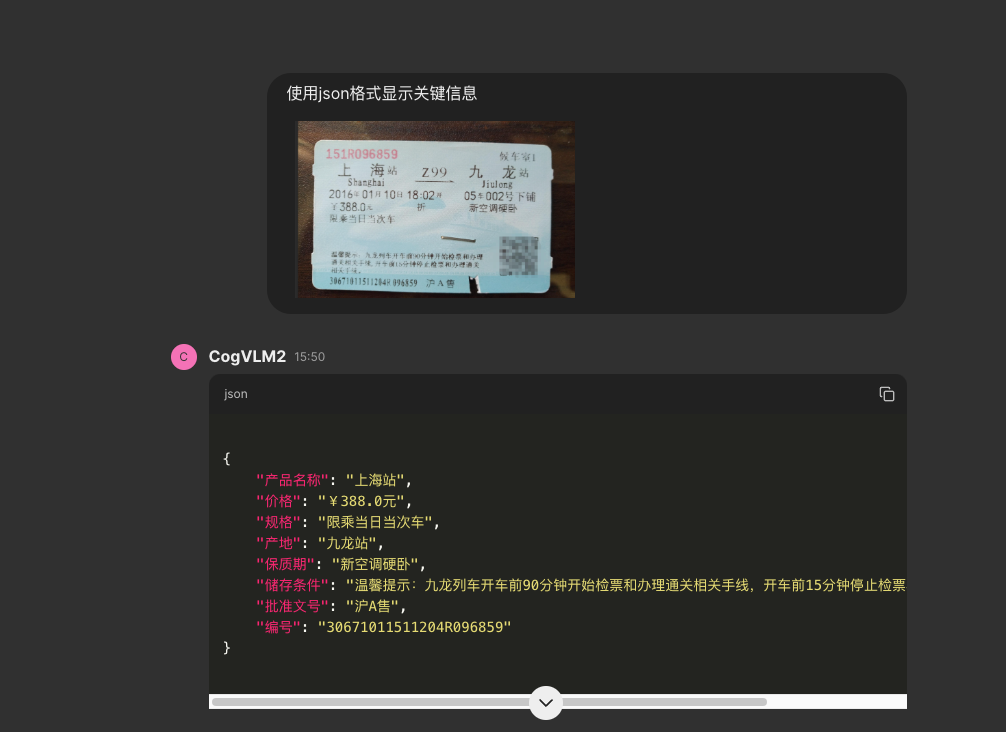

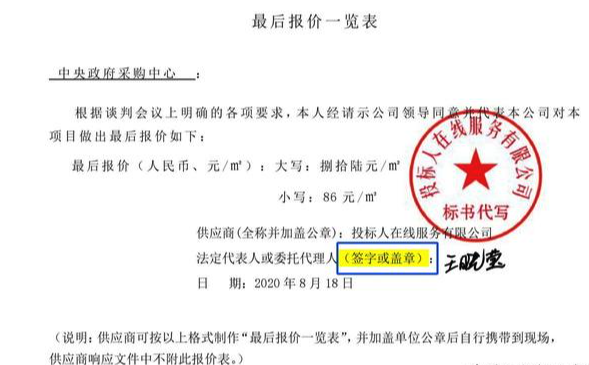

效果

- 成份表

- 火车票

这里键的含义不对, int4 估计会有性能损失导致的

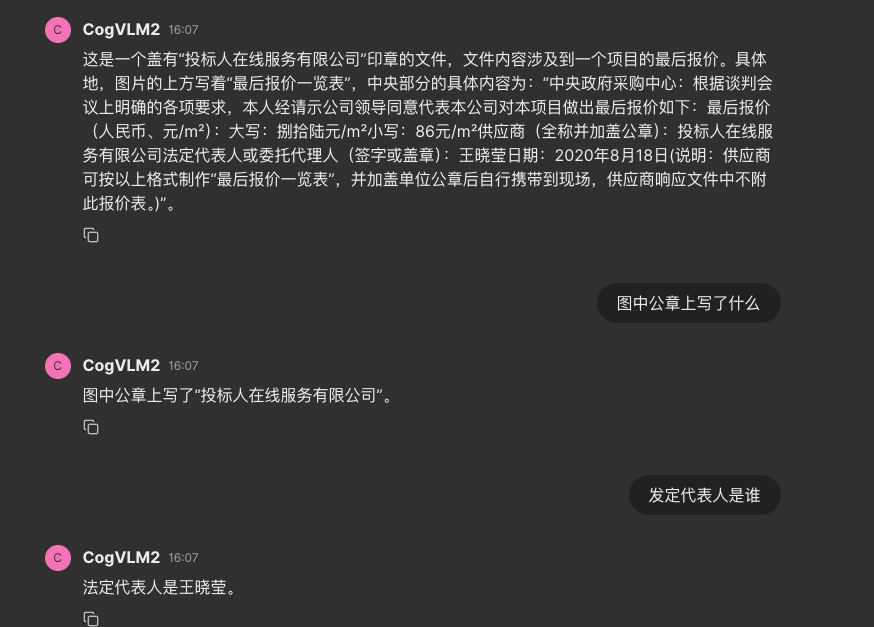

- 盖了章的报价表

OpenAI API

使用 OpenAI API格式的方式请求和模型的对话。

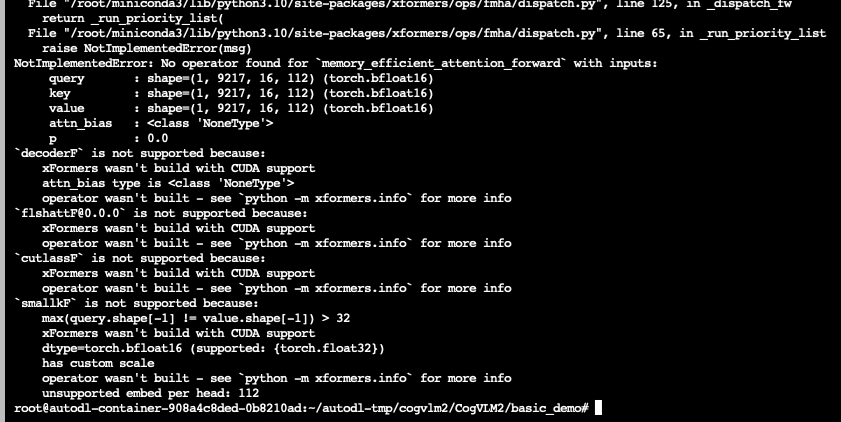

错误解决

解决办法 :使用下面requirements.txt重新安装依赖

- 作者:何以问

- 链接:https://heyiwen.com/article/ai-1

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。

.jpg?table=collection&id=e7f4915d-967b-426f-8bcd-25b05e1a8ebb&t=e7f4915d-967b-426f-8bcd-25b05e1a8ebb&width=1080&cache=v2)